Webinaire – Implications perceptives et optimisation des simplifications conçues pour l’expérience auditive en Réalité augmentée/virtuelle – Vincent Martin (Imperial College, Londres)

Résumé

Vincent Martin est actuellement chercheur en contrat post-doctoral au sein de l’équipe Audio Experience Design à l’Imperial College de Londres, après un doctorat à l’IRCAM en septembre 2022. Il travaille sur la pertinence perceptuelle des caractéristiques des simulations acoustiques. Ses principaux intérêts de recherche portent sur l’audio immersif, le rendu audio spatial et la localisation des sources sonores virtuelles.

L’émergence de technologies grand public abordables pour l’écoute audio spatiale a été principalement motivée par le compromis entre la fidélité du rendu et l’efficacité en termes d’informations sur l’auditeur et l’environnement, ainsi que de puissance de calcul requise. En effet, le rendu en temps réel de l’audio spatial est devenu une exigence pour les applications de réalité virtuelle (VR) et de réalité augmentée (AR).

Initialement, il est apparu nécessaire de reproduire les fonctions de transferts de la tête de l’auditeur, connues sous le nom de HRTF. Ces dernières décrivent comment un son est altéré entre sa source d’émission et l’entrée du canal auditif de l’auditeur, avec des variations basées sur les caractéristiques anthropométriques de l’auditeur. La modification du son par le corps de l’auditeur dépend de facteurs tels que l’absorption, la diffraction et la transmission, impliquant ainsi la nécessité d’une mesure individualisée de la HRTF pour une simulation audio spatiale optimale. Mesurer les HRTF est possible, mais cela nécessite un système de mesure coûteux. Pour contourner ces contraintes, il est possible de créer une spatialisation sonore en utilisant une HRTF d’un mannequin humain, et c’est d’ailleurs ce qui a été généralement fait jusqu’à présent, par exemple, dans les systèmes de réalité virtuelle. Parallèlement, la capacité à reproduire l’effet de salle est également cruciale pour les applications audio spatiales afin de fournir à l’utilisateur une reproduction fidèle des indices perceptuels liés à l’environnement sonore.

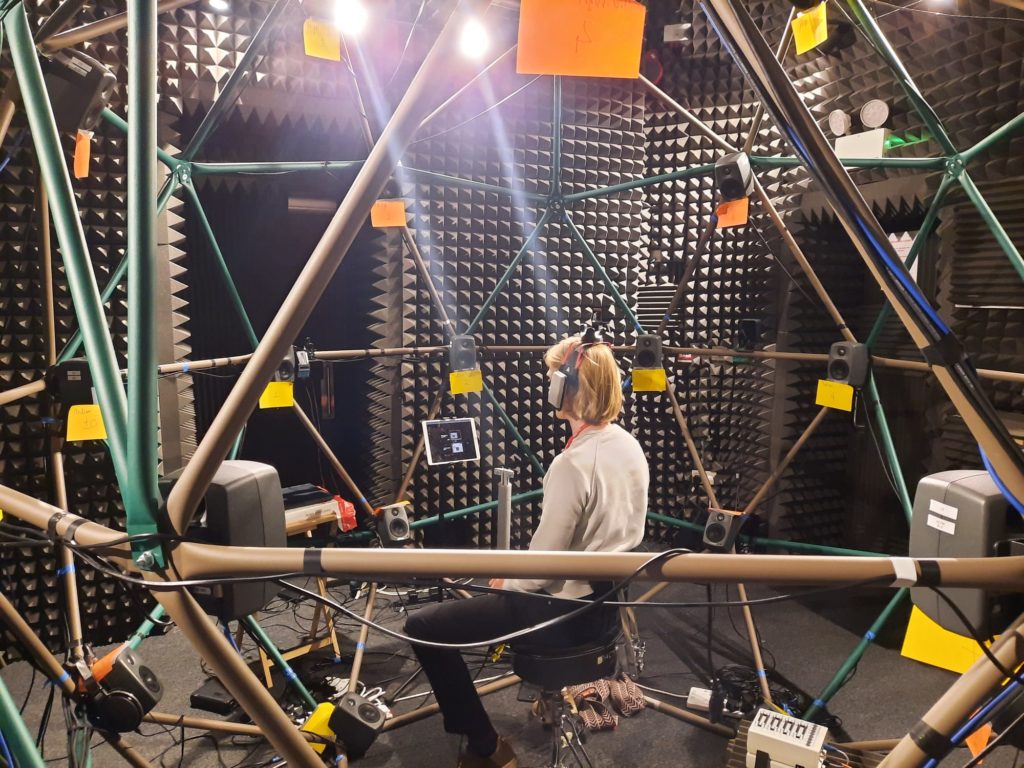

Cette présentation englobe deux études distinctes. La première explore un scénario de réalité augmentée évaluant l’importance de la reproduction de la HRTF d’un participant. Le participant est placé au centre d’une sphère de haut-parleurs, devant évaluer la localisation et le réalisme de sources sonores réelles et virtuelles. Les procédés de rendu des sources virtuelles varient, incluant la reproduction de la réverbération de la salle, l’utilisation d’une HRTF individualisée, et la possibilité de bouger la tête durant la présentation des stimuli sonores. La seconde étude se concentre spécifiquement sur le rendu de la réverbération. L’objectif est d’examiner les implications perceptuelles de la simplification de la géométrie de la pièce et de la résolution en fréquence des coefficients d’absorption. Plusieurs modèles décimés basés sur une seule pièce ont été évalués de manière perceptive et numérique, utilisant deux tests perceptifs indépendants basés sur le paradigme MUSHRA, l’un avec un casque VR et l’autre à distance sur ordinateur.

L’objectif global de ces deux travaux est d’améliorer la compréhension des caractéristiques de la réverbération et de l’individualisation nécessaires pour obtenir une expérience auditive réaliste d’un point de vue perceptif. En résumé, ces deux études explorent la question fondamentale : dans quelle mesure pouvons-nous simplifier une simulation d’audio spatiale en termes de réverbération et d’individualisation tout en maintenant une expérience plausible?

Lundi 5 février 2024 à 11h

Lien : https://univ-amu-fr.zoom.us/j/88956645351?pwd=NFFESEx4UzY4UE9FdUE4L3A2aFpXdz09

ID de réunion : 889 5664 5351

Code secret : 151443